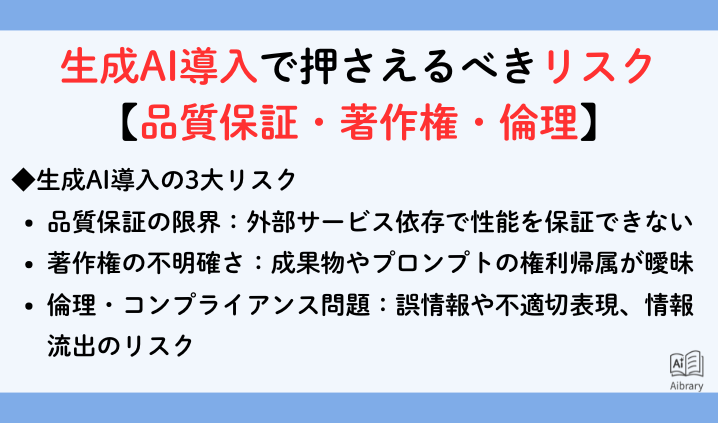

生成AI導入で押さえるべきリスク【品質保証・著作権・倫理】

生成AIは業務効率化やサービスの高度化に大きな可能性をもたらします。しかし導入の裏側には、法務・契約・倫理面で見過ごせないリスクが潜んでいます。本記事では、企業が生成AI導入時に直面しやすい代表的な3つのリスクを整理し、トラブルを避けるためのポイントを解説します。

この記事のポイント

- 生成AIは外部サービス依存のため性能保証が困難

- 成果物の著作権帰属を明確にしないと紛争リスクが高まる

- プロンプトも著作物と認められる可能性がある

- 誤情報や不適切表現など倫理的リスクも存在する

- 契約条項・社内ルール・ガバナンス体制でリスクを制御することが不可欠

【参照元】一般社団法人日本ディープラーニング協会「生成AI開発契約ガイドライン」

リスク①:品質保証の限界

生成AIの多くは外部ベンダが提供するサービスを利用しています。そのため、開発ベンダはAIモデル自体の性能を保証できません。

- 外部サービスの仕様変更や提供停止は予測不能

- 契約条項でも「品質保証しない」と明記されるケースが多い

- 性能に関する数値的な保証を結ぶのは極めて難しい

ユーザは「品質保証は限定的」と理解したうえで、契約に盛り込む範囲を見極める必要があります。

リスク②:著作権・知財の不明確さ

生成AIの契約では、著作権の所在が曖昧になりやすい点もリスクです。

- AIモデルは外部ベンダが権利を持つ

- 問題になるのはRAGシステム、プロンプト、周辺プログラムなどの成果物

- 成果物の著作権帰属を契約で明確にしないと、後の利用制限や紛争につながる

特にプロンプトは長文や独自性が高い場合「著作物」と認められる可能性があるため、契約書で扱いを定めておく必要があります。

リスク③:倫理・コンプライアンス問題

生成AIは便利な一方で、倫理的リスクも伴います。

- 誤情報や差別的・不適切な表現が生成される可能性

- 個人情報や機密情報を誤って学習や利用に回すリスク

- 倫理リスクを軽視すると、企業のブランド毀損や法的責任につながる

対策としては「AI品質保証コンソーシアム」の基準や、行政が発表している調達ガイドラインを参考にするのが有効です。

企業が取るべき対策

リスクをゼロにすることはできませんが、以下の対応で影響を最小限に抑えられます。

- 契約で「品質保証の範囲」を明確化する

- 成果物の著作権帰属を定義し、将来的な利用制限を防ぐ

- 倫理・コンプライアンス対応を含めた社内ルールを整備する

- ベンダ選定時からリスク評価を行い、ガバナンス体制を確立する

まとめ

生成AI導入はメリットが大きい一方、品質保証の限界、著作権の曖昧さ、倫理的なリスクという3つの落とし穴があります。重要なのは、これらを「避けられない前提」として認識し、契約や運用ルールで制御していくことです。リスクを正しく理解し対策を講じることで、生成AIの力を安心して活用できるようになります。