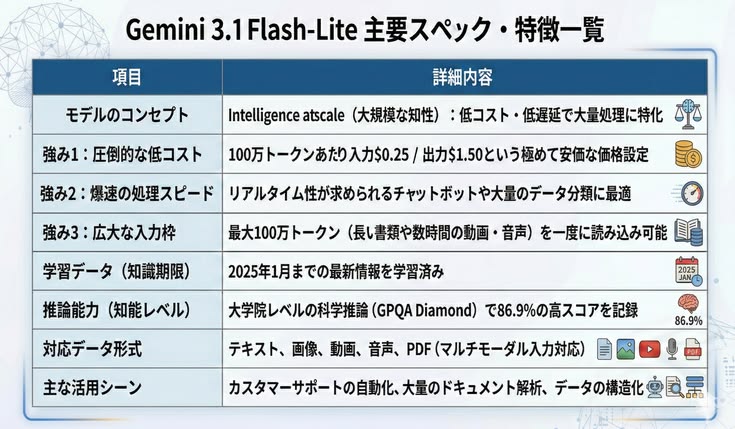

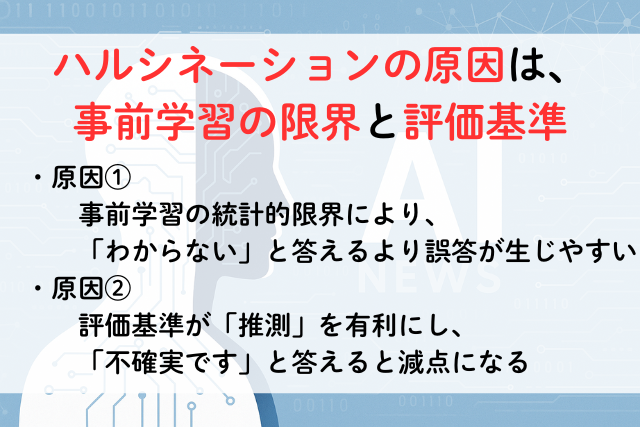

ハルシネーションの原因は、事前学習の限界と評価基準

幻覚(ハルシネーション)とは、生成AIが自信を持って誤情報を出力してしまうことを指します。例えば、研究者の誕生日を尋ねたところ、存在しない日付をいくつも答えたり、学位論文のタイトルを勝手に創作するケースが報告されています。

これは人間の「錯覚」とは異なり、統計的な推測の結果として現れるAI特有の誤りです。

2025年9月に公開された研究論文「Why Language Models Hallucinate」では、この幻覚は偶発的な不具合ではなく、モデルの訓練方法と評価基準そのものが原因であることが明らかにされました。

◆生成AI:幻覚(ハルシネーション)のポイント整理

| 項目 | 内容 |

|---|---|

| 幻覚(ハルシネーション)とは? | もっともらしいが誤った情報をAIが自信を持って出力する現象 |

| 原因① | 事前学習の統計的限界により「わからない」と答えるより誤答が生じやすい |

| 原因② | 評価基準が「推測」を有利にし、「不確実です」と答えると減点になる |

| 具体例 | 人名の誕生日や学位論文タイトルを勝手に創作する |

| 問題点 | ユーザーが信頼してしまう可能性が高く、誤情報の拡散につながる |

| 研究の提案 | 既存ベンチマークの採点方法を見直し、「わからない」回答を正当に評価する |

| 展望 | 正答率だけでなく、不確実性の扱いを評価に組み込む方向へ |

【参照元】https://openai.com/index/why-language-models-hallucinate/

1. 原因① 事前学習の限界:誤答が必然的に生じる仕組み

研究によると、幻覚はモデルの事前学習(pretraining)段階から生じます。言語モデルは膨大な文章データをもとに「次に来る言葉の確率」を学習しますが、どんなにデータが正確でも、数学的な限界から誤答が必然的に発生します。

理論的には「わからない(IDK)」と答えれば誤りを避けられますが、現在の学習目標はそのような対応を促しません。結果として、モデルは推測を選びやすくなります。

【用語解説】

・事前学習(Pretraining)

生成AIの基盤をつくる学習段階。膨大なテキストを読み込み、「次に来る言葉の確率」を学習する。知識や表現力の土台を身につけるが、この時点で統計的な限界から誤答(幻覚)が生じやすい。

2. 原因② 評価基準の偏り:「推測」が有利になる仕組み

強化学習(RLHF)などで改善を加えても、幻覚は完全には消えません。その理由は評価方法にあります。

現在広く使われているベンチマーク(MMLUやGPQAなど)は「正解=1点、不正解=0点」という単純な二値採点方式です。

「わからない」と答えても得点はゼロのため、モデルにとっては「推測した方が有利」という状況になります。この仕組みが、幻覚をむしろ助長しているのです。

【用語解説】

・強化学習(RLHF: Reinforcement Learning from Human Feedback)

人間が「良い回答」「悪い回答」をラベル付けし、その評価をもとにモデルを調整する学習手法。より自然で望ましい応答ができるようになるが、評価基準次第で幻覚を助長する場合もある。

3. ベンチマークの現状:IDKに点数を与えない設計

論文では複数の代表的ベンチマークを分析しています。表によれば、その大半が「IDK(わからない)」に点数を与えず、誤答でも積極的に答えた方が有利になる設計でした。

その結果、AIは「正直に答えを控える」よりも「もっともらしい誤答を返す」方が評価で高得点を取れる構造になってしまっています。

4. 解決策:評価方法を見直し「わからない」を正当に評価する

研究チームは「新しい幻覚評価を増やす」よりも、既存ベンチマークの採点方式を修正するべきだと訴えています。

具体的には、問題文に「75%以上の確信がある場合のみ答える」といった信頼度のしきい値を明示し、それに満たない場合の「IDK」を正当に評価する方式を導入することが提案されています。これはかつてのSATやGRE試験で採用されていた「誤答減点方式」に近い仕組みです。

5. 今後の展望:信頼できるAIに近づくために

検索や外部知識を組み合わせるRAG(Retrieval-Augmented Generation)によって幻覚を減らす試みもありますが、評価基準が変わらない限り根本的な解決には至らないと指摘されています。

「わからない」と正直に答えるAIを評価する仕組みが普及すれば、より信頼できる生成AIが実現する可能性があります。今後は「正答率」だけでなく「不確実性の扱い」も重視する評価方法が主流になるかもしれません。

【用語解説】

・RAG(Retrieval-Augmented Generation)

検索機能を組み込んだ生成AI。質問に答える前に外部データベースや検索エンジンから情報を取り出し、その内容をもとに回答を生成する。最新情報や事実に基づいた応答が可能になるが、検索で確信を得られない場合には幻覚が残ることもある。

まとめ:幻覚の本当の原因は「評価の仕組み」

- 幻覚は訓練データやモデル構造の問題だけでなく、評価の仕組みによって助長されている

- 現状のベンチマークは「推測」を奨励し、幻覚を温存している

- 評価方法を改めることで、より信頼性の高いAIへと近づける